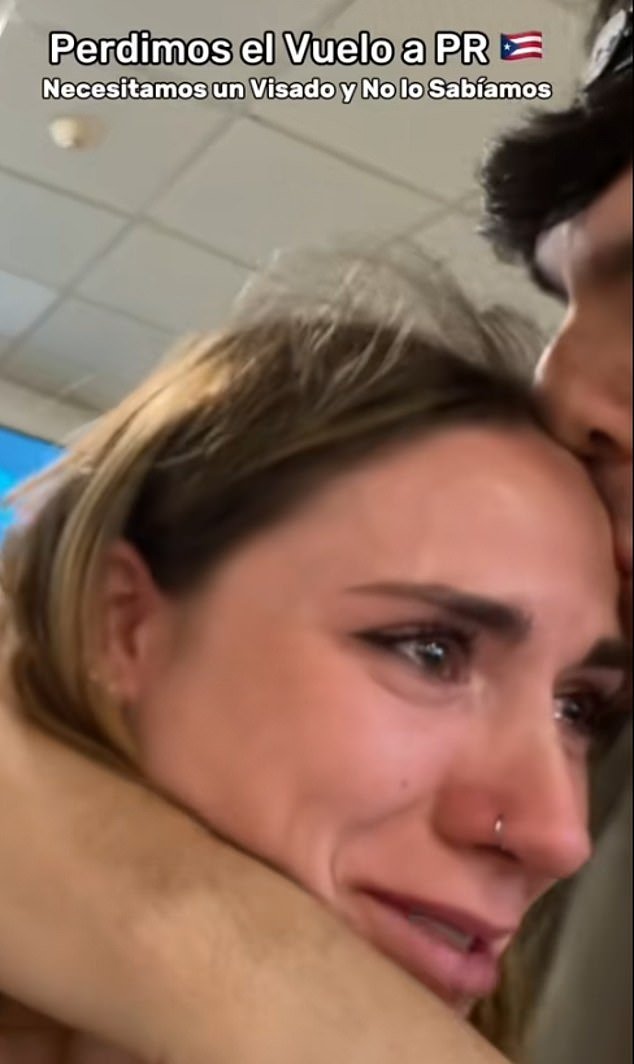

Una joven pareja de influencers dijo que se les prohibió abordar su vuelo a Puerto Rico después de que Chatgpt les dio la mala información sobre la visa para ingresar a la isla del Caribe.

En un video compartido por turistas españoles en las redes sociales, Tiktker Mery Caldass aparece llorando mientras cruza el aeropuerto después de que se le permita viajar.

Mientras que el compañero Alejandro Cid la consuela, Caldass le dice a la cámara: « Escucha, siempre investigo mucho, pero le pregunté a ChatGpt y dijeron que no: « refiriéndose para saber si necesitaba una visa para ingresar al país.

«Ya no confío en este hijo de Ab *** H», agrega.

Pero entre sus lágrimas, la broma influye en que la herramienta AI les dio la información incorrecta como un acto de venganza después de haberla insultado.

«Ya no confío en este porque a veces lo insulto, lo llamo Ab ***** D, eres inútil, pero me junto … es su venganza».

El video ha acumulado 6.1 millones de visitas sobre Tiktok y varios usuarios se rieron de la pareja por pedirle información a ChatGPT en lugar de verificar los consejos oficiales de viaje.

«Bueno, selección natural, supongo. Si vas a hacer un viaje transoceánico y pones todos tus consejos en ChatGPT, poco te sucedió», dijo un usuario.

Se impidió que una joven pareja de influencers subiera su vuelo a Puerto Rico después de que Chatgpt les dio la mala información sobre la visa.

La influencia Mery Cladass y su novio Alejandro Cid publicaron un video sobre Tiktok después de su evento. La entrada de la pantalla muestra a Caldass que llora en un aeropuerto después de ser excluidos de su vuelo

«¿Pero quién confía en Chatgpt para este tipo de situaciones?» Dijo otro.

Otros llegaron a la defensa de Chatgpt, diciendo que la respuesta de la herramienta AI no era incorrecta y que, en cambio, la pareja le había hecho la mala pregunta sobre los documentos necesarios para ingresar a Puerto Rico.

Los turistas españoles no necesitan una visa para ingresar a la isla del Caribe, pero los turistas deben procesar una Autorización de Viajes Electrónicas (ESTA) en línea.

La prueba de la pareja con ChatGPT ocurre un día después de que un hombre luchó por su salud mental después de reemplazar la sal de la mesa con un químico más comúnmente utilizado para limpiar las piscinas después de haber seguido el consejo de la IA.

El veloz de 60 años pasó tres semanas en el hospital con alucinaciones, paranoia y ansiedad severa después de recibir consejos de alimentos de ChatGPT.

Los médicos revelaron en un periódico médico estadounidense que el hombre había desarrollado el bromismo, una condición que prácticamente ha destruido desde el siglo XX, después de haber lanzado una «experiencia personal» para cortar la sal de su dieta.

En lugar de usar cloruro de sodio diario, el hombre lo intercambió por bromuro de sodio, un compuesto tóxico anteriormente se vendió en píldoras sedantes, pero ahora principalmente en productos de limpieza de piscinas.

Los síntomas del bromismo incluyen psicosis, delirios, erupciones y náuseas, y en el siglo XIX, estaba relacionado con el ocho por ciento de las admisiones psiquiátricas al hospital.

El influencer bromeó diciendo que la herramienta IA le había dado la información equivocada como un acto de venganza después de insultarlo

En la foto: La influencia española Mery Caldass, que tiene casi 400,000 suscriptores en Instagram

El video de Caldass y CID ha acumulado más de 6 millones de visitas en las redes sociales

El extraño caso dio un giro inquietante cuando el hombre se presentó a un servicio de emergencia al insistir en que su vecino estaba tratando de envenenarlo.

No tenía antecedentes de enfermedad mental.

Intrigados y alarmados, los médicos probaron los mismos Chatgpt. El bot, dijeron, siempre recomendaban el bromuro de sodio como una alternativa a la sal, sin mencionar el riesgo para la salud.

Anuncio